Un ordenador moderno necesita, entre otros, de un procesador y una tarjeta gráfica para funcionar. La inauguración de este año del Computer Show 2023 celebrado en Taipéi, el CEO de NVIDIA ha empezado a repartir palos. Concretamente, le ha pegado un gran palo a Intel, diciendo que las GPU reducen notablemente el coste y consumo de energía para inteligencia artificial.

Para quien no lo sepa, NVIDIA se ha posicionado de manera clara y contundente en el mercado de la IA. Jensen Huang, CEO de NVIDIA, ha sido un pionero en este sector, viendo las posibilidades del mercado. Ofrece soluciones muy especializadas que aportan una gran potencia de cómputo con gran eficiencia.

Las CPU son altamente ineficientes

Durante su discurso, Huang ha desafiado directamente a la industria de procesadores. Ha destacado que la inteligencia artificial generativa y la computación acelerada son el futuro de la computación.

El gran palo ha llegado cuando afirma que la Ley de Moore está desactualizadas. Destaca que las futuras mejoras de rendimiento vendrán dadas por la IA generativa y la computación acelerada. Vamos, todo un golpe a Intel, ya que Gordon E. Moore (quien postulo la Ley de Moore) es uno de los fundadores de la compañía.

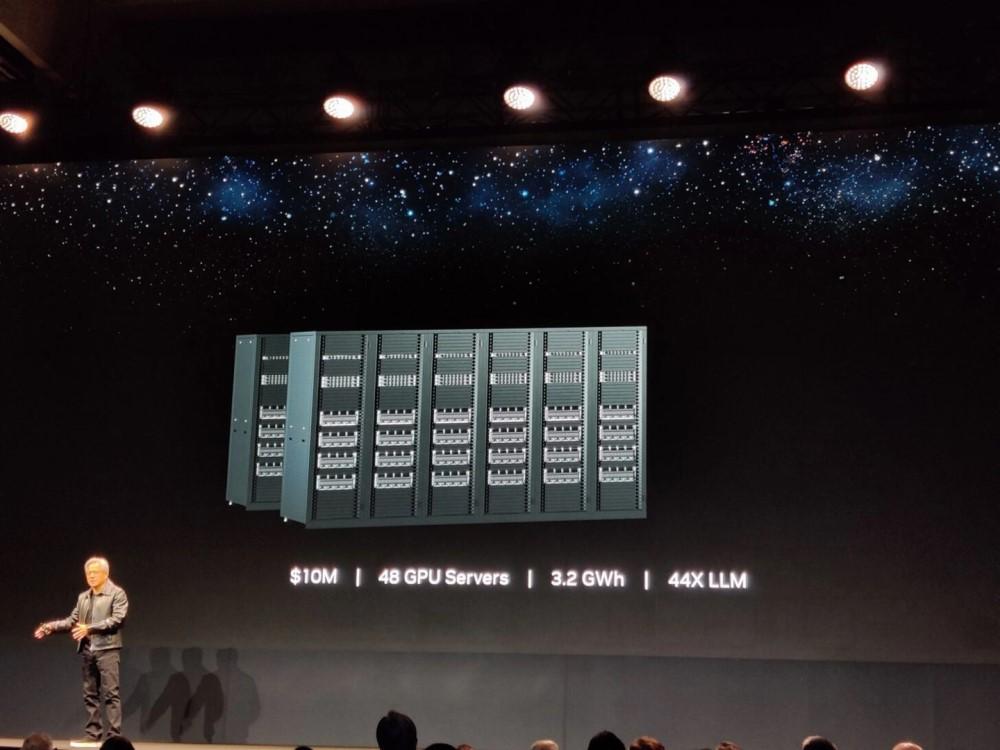

A fin de afianzar la posición, han mostrado un análisis del costo de la computación acelerada (CA). Han dado datos del costo total de un clúster de servidores con 960 procesadores, que se usaría para la CA. Se ha tenido en cuenta toda la infraestructura, como es chasis, interconexiones y otros elementos.

Según los datos que han dado, todos estos elementos cuestan unos 10 millones de dólares. Además, se destaca que el consumo sería de unos 11 gigavatios/hora.

Huang compara estos datos con un clúster de GPU de 10 millones de dólares que permitiría entrenar hasta 44 modelos de computación acelerada, por el mismo precio. No solo eso, aseguran que el consumo sería de unos 3.2 gigavatios/hora, casi 4 veces menos consumo de energía.

Según indica Huang, un sistema que consuma 11 gigavatios/hora podría entrenar hasta 150 modelos de computación acelerada. Pero cuidado, este sistema tendría un coste de 34 millones de dólares.

Pero, además, se establece que entrenar solo un modelo computación acelerada, se requiere un sistema de 400.000 dólares que consume tan solo 0.13 gigavatios/hora.

Quiere dejar claro que para entrenar un modelo de computación acelerada tiene un coste del 4% con respecto a un sistema basado en CPU y reduce el consumo de energía se reduce en un 98.8%.

Entoces, ¿los procesadores tienen los días contados?

No, la verdad. Se siguen necesitando actualmente, debido a que hacen las funciones de gestión, por decirlo de manera muy simplificada. Lo que nos cuenta Huang es que un sistema basado en procesadores es más ineficiente y costoso que uno basado en GPU.

Pese a esto, cualquier servidor, clúster o sistema avanzado requiere un procesador (o varios). La gran ventaja de las GPU es la computación paralelizada masiva, algo que es beneficioso para la IA, que requiere de millones de operaciones por segundo.

Lo que destaca Huang es bastante evidente, que los procesadores x86 son bastante ineficientes. Esto está provocando que muchos exploren las soluciones basadas en RISC y RISC-V. Son arquitecturas más eficientes, pero también mucho menos potentes.

The post NVIDIA le da un palo a Intel: «los procesadores son muy ineficientes» appeared first on HardZone.

from HardZone https://ift.tt/n2iwYOH

via IFTTT

No hay comentarios:

Publicar un comentario